Google ha tenido una semana muy activa en lo que respecta a innovaciones e inteligencia artificial. Ayer asombró a todos al presentar Bard, su propia IA conversacional, y hoy dio a conocer el Live from Paris, un evento digital que se llevó a cabo hoy mismo, donde mostró varias novedades diseñadas para optimizar la experiencia de búsqueda de sus usuarios, que, por supuesto, también están respaldadas por inteligencia artificial.

Es relevante mencionar que el coloso tecnológico ya había presentado algunas de estas innovaciones en el evento Search On 2022, realizado el pasado mes de septiembre. Sin embargo, sigue siendo interesante recordarlas y descubrir el resto de las funciones nuevas que las complementan y que facilitarán que «la exploración de la información en la búsqueda sea aún más natural e intuitiva«.

Multibúsqueda: texto e imagen a tu disposición

Esta fue, sin duda, la innovación más destacada presentada por Google en el Search On 2022. En esta ocasión, el gigante tecnológico la ha mencionado nuevamente, recordando que ya se puede utilizar en todos los países e idiomas donde Google Lens está accesible.

La multibúsqueda combina la IA y la percepción visual de Google Lens con la búsqueda basada en texto. De esta manera, Google integra la información y el contexto que ambos métodos proporcionan para ofrecer resultados mucho más completos y precisos. Su funcionamiento es extremadamente sencillo e intuitivo, solo necesitas acceder a Google Lens y capturar o subir una imagen para luego deslizar hacia arriba la barra de resultados y hacer clic en «agregar a tu búsqueda» para escribir lo que desees para completar tu búsqueda.

Descubre lo que necesites cerca de ti gracias a la búsqueda local

Además, la multibúsqueda también permite especificar si deseamos obtener resultados locales. Para ello, solo hay que escribir «cerca de mí».

al extraer o elevar la imagen de nuestra búsqueda. Esta es una manera de respaldar a los negocios locales y estimular el consumo en ellos. Por el momento, esta función únicamente está accesible en inglés en EE.UU., aunque Google ya ha indicado que en los próximos meses estará disponible en el resto del mundo.

Google Lens: «Si puedes observarlo, puedes buscarlo»

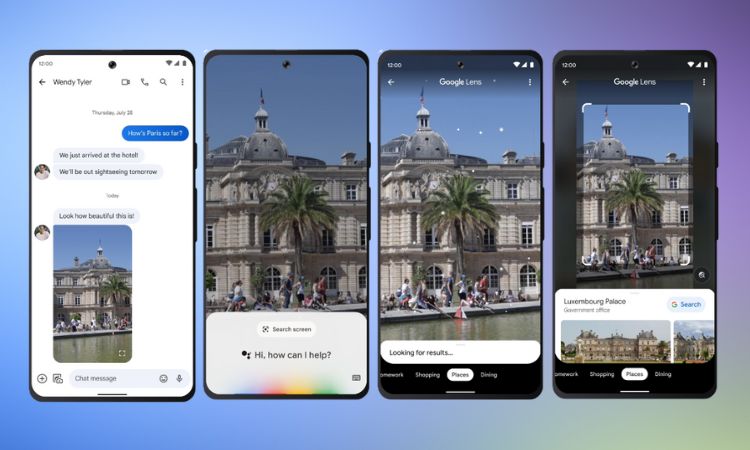

Con esta afirmación, Google ha introducido la última evolución de Lens, su tecnología de búsqueda visual, que hasta ahora permitía reconocer y buscar información sobre los elementos que aparecían en cualquier imagen o, directamente, en la pantalla del usuario de un móvil al utilizar su cámara. Google Lens surgió como una aplicación en 2017 y desde entonces ha ido perfeccionando sus capacidades basándose en desarrollos relacionados con la IA. Actualmente, según datos de la misma Google, Lens se emplea más de 10.000 millones de veces al mes

En adelante, los usuarios podrán utilizar Lens para «localizar lo que se muestra en tu pantalla» en cualquier dispositivo Android. Esta tecnología te permitirá investigar lo que observas en fotos o vídeos en todo tipo de sitios web y aplicaciones (como las aplicaciones de mensajería y de vídeo), sin la necesidad de salir de la aplicación o de interrumpir la experiencia. Es decir, a partir de ahora, los usuarios de Whatsapp podrán acceder a las funcionalidades de Lens para reconocer los elementos que aparecen en un vídeo enviado a través de la app de Meta, sin necesidad de abandonarla.

«Imagina que unos amigos te envían un mensaje con un vídeo en el que aparecen dando un paseo por París. De repente, aparece un monumento al fondo. ¿Deseas saber qué es? Realiza una pulsación larga en el botón de encendido o de inicio de tu teléfono Android (el que activa el Asistente de Google). Después, selecciona «buscar pantalla». ¡Y entonces Lens lo reconoce como el Palais du Luxembourg! Si tocas nuevamente, obtendrás más detalles», aclara Google en su comunicado.

Google Live View: vista de calle + realidad aumentada + IA

Live View es «una forma completamente innovadora de explorar sitios», explica Google sobre esta actualización de su manera de visualizar lugares en su popular herramienta Maps. Una nueva evolución de su conocido Street View que «te hace sentir como si ya estuvieras allí… aunque nunca hayas estado. Gracias a los avances en IA y en visión artificial, esta función combina miles de millones de imágenes aéreas y de Street View para crear un modelo digital del mundo, repleto de detalles. Además, le superpone información útil, como el clima, el estado del tráfico y la concurrencia de un lugar».

La nueva Live View de Google aprovecha las capacidades de la inteligencia artificial y la realidad aumentada para enriquecer la experiencia de búsqueda de lugares de los usuarios. Esta nueva función, que ya está operativa en Londres, Los Ángeles, Nueva York, París, San Francisco y Tokio, llegará «en los próximos meses» a Madrid, Barcelona y Dublín y permitirá incluso incorporar funcionalidades de realidad aumentada a los interiores de espacios públicos. Así, como detalla Google en un ejemplo, «superpone flechas de realidad aumentada que indican la dirección.en la que necesitas andar para localizar con agilidad y seguridad lo que deseas. En los meses venideros, esta funcionalidad te ayudará a desplazarte por más de mil nuevos aeropuertos, estaciones de tren y centros comerciales».

Asimismo, estas actualizaciones se aplicarán a los movimientos de los usuarios, independientemente del medio de transporte elegido, incluyendo la bicicleta o el transporte público, brindando información útil como el tiempo de llegada a tu destino e indicaciones sobre cuál es la dirección que debes seguir. Estas orientaciones comenzarán a visualizarse en todo el globo en dispositivos Android e iOS en los próximos meses.

Google Vista Inmersiva, representaciones 3D de la realidad en Maps

Dentro del ámbito de Maps, Google también anunció la llegada de Vista Inmersiva, que se implementará a partir de hoy en Londres, Los Ángeles, Nueva York, San Francisco y Tokio. Una innovación que utiliza la inmensa cantidad de imágenes de Street View y fotografías aéreas que posee Google para crear recreaciones tridimensionales de la realidad.

«Supongamos que planeas una visita al Rijksmuseum de Ámsterdam. Puedes volar virtualmente sobre el edificio y observar dónde están las entradas. Con el control deslizante de tiempo, puedes ver cómo luce el área en diferentes momentos del día y cuál será el clima. También puedes identificar dónde suele haber más afluencia, para que tengas toda la información necesaria para decidir dónde y cuándo ir. Si tienes hambre, deslízate hasta el nivel de la calle para explorar los restaurantes cercanos e incluso echa un vistazo al interior para comprender rápidamente el ambiente de un lugar antes de hacer tu reserva.

Para crear estas escenas realistas, empleamos campos de radiación neuronal (NeRF), una técnica avanzada de inteligencia artificial que convierte imágenes comunes en representaciones tridimensionales. Gracias a NeRF, podemos recrear con precisión el entorno completo de un lugar, incluida su iluminación, la textura de los materiales y el fondo. Todo esto permite discernir si la iluminación cambiante de un bar es el ambiente adecuado para una cita nocturna o si las vistas de un café lo convierten en el lugar ideal para almorzar con amigos».

Traductor contextual: obtén una mayor precisión en tus traducciones

El gigante tecnológico también ha realizado anuncios significativos en relación a su traductor y las nuevas capacidades que incorpora, las cuales han sido impulsadas gracias a la inteligencia artificial. La primera de la que hablaremos permite mejorar la traducción gracias a la comprensión del contexto alrededor de la frase.

Imagina tener la posibilidad de conseguir una traducción precisa, que utilice los giros adecuados en el lenguaje, modismos locales o términos más apropiados para tratar el tema que deseas comentar. Ahora esto será factible, ya que el traductor de Google te brindará traducciones con más contexto, descripciones y ejemplos en el idioma que elijas. Adiós a las palabras y frases con significados múltiples y a la confusión sobre cuál es el correcto en cada situación.

Esta funcionalidad llegará a nuestros dispositivos en las semanas próximas y estará disponible en inglés, español, francés, alemán y japonés, entre otros idiomas.

Por otro lado, es importante señalar y celebrar la adición de 33 nuevos idiomas al traductor de Google. Entre ellos se encuentran el euskera, el corso, el hawaiano, el hmong, el kurdo, el latín, el luxemburgués, el sudanés, el yiddish o el zulú.

Traductor de imágenes: traduce respeando la imagen original

Finalmente, nos encontramos con otra novedad que ya había sido anunciada en septiembre del año pasado: la mejora del traductor de imágenes integrado en Google Lens. Este ya permitía traducir textos presentes en imágenes simplemente enfocándolos con nuestra cámara, pero el resultado no se integraba de manera natural en la imagen, sino que aparecía resaltado por barras que ocultaban parte de la imagen.

No obstante, esto ha cambiado, ya que gracias a la inteligencia artificial, Google Lens es capaz de traducir los textos de las imágenes y recrear con exactitud el fondo completo de cada palabra.

Foto: Google