“`html

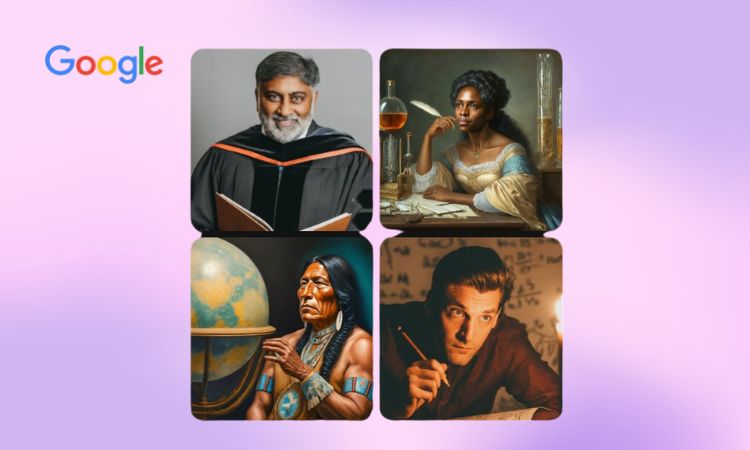

Google ha dado a conocer que suspenderá la funcionalidad de creación de imágenes de personas en Gemini (anteriormente Bard) mientras aborda inconvenientes relacionados con «imprecisiones en algunas representaciones históricas».

Esto sucede pocos días después de que varios usuarios señalaran a la empresa a través de redes sociales, de maneras más o menos efectivas, que su IA generadora de imágenes estaba representando personajes históricos o personas de épocas pasadas de manera incorrecta.

This is not good. #googlegemini pic.twitter.com/LFjKbSSaG2

— John L. (@JohnLu0x) February 20, 2024

Google detiene sus funciones de creación de imágenes de personas

Ayer, 21 de febrero, Google optó por publicar un breve aviso en X para tranquilizar a la audiencia. «Estamos al tanto de que Gemini presenta imprecisiones en algunas representaciones históricas generadas como imágenes. Nos encontramos en procesos de mejorar este tipo de representaciones de inmediato. La generación de imágenes por parte de Gemini crea una vasta variedad de personas. En general, esto es algo positivo ya que es utilizado por personas globalmente. Sin embargo, aquí no se acierta».

Sin embargo, parece que esto no ha sido suficiente, pues hace apenas unas horas la empresa volvió a comunicarse en esta plataforma, esta vez para informar que desactivarán la capacidad de creación de personas en su herramienta hasta que se resuelvan las dificultades. «Estamos abordando problemas recientes con la función de generación de imágenes de Gemini. Mientras tanto, pausaremos la generación de imágenes de personas y pronto lanzaremos una versión mejorada».

We’re already working to address recent issues with Gemini’s image generation feature. While we do this, we’re going to pause the image generation of people and will re-release an improved version soon. https://t.co/SLxYPGoqOZ

— Google Communications (@Google_Comms) February 22, 2024

La IA y la diversidad, una conexión complicada

Mientras algunos usuarios han decidido resaltar las inconsistencias de las imágenes generadas con Gemini, subrayando la necesidad de representar momentos históricos con exactitud, otros han utilizado la viralidad del asunto para propagar mensajes nocivos y racistas.

Es evidente que existe una diversidad de intenciones entre quienes indican que para crear una imagen de un soldado nazi no debería aparecer una persona asiática y aquellos que se indignan porque ante el requerimiento «mujer norteamericana» la IA produzca imágenes de mujeres afrodescendientes,

“`de origen asiático o que simplemente no sean de piel clara.

La representación y la pluralidad en la IA, al igual que en todos los elementos de la existencia, son esenciales. No hay un solo tipo de «mujer norteamericana», y afirmar lo contrario es rechazar la realidad y ignorar a todas aquellas mujeres que no se ajustan al patrón que ciertos individuos han determinado como el correcto.

Hace menos de dos años, con el propósito de identificar los sesgos de la IA, evaluamos diversas herramientas y logramos establecer que efectivamente presentaban sesgos de género, raza, orientación sexual y edad. De igual manera, hace apenas unos días repetimos el experimento, pero esta vez enfocándonos en sesgos de género y sexualización. Aunque entre un artículo y el otro los progresos en IA han sido significativos, la diversidad sigue siendo una materia pendiente para esta tecnología.

Que los intentos de Google por eliminar sesgos en su IA hayan resultado en «imprecisiones históricas» debería considerarse algo anecdótico. Es un aspecto que, sin duda, la empresa podrá corregir en poco tiempo, mientras que la intolerancia es un desafío que, como se ha demostrado, nos costará mucho más erradicar.